¿Qué son los sesgos cognitivos y cómo usarlos para trabajar mejor?

10 trucos de Python que no conoces.

¿Qué es Structural Pattern Matching de Python y por qué todos hablan de él?

¿Qué es Seldon y por qué debes conocerlo si trabajas con Machine Learning?

¿Cómo crear visualizaciones de datos increíbles con Apache Superset?

Fluyendo más y mejor con Airflow 2.0.0.

Ética e IA: una mirada al futuro.

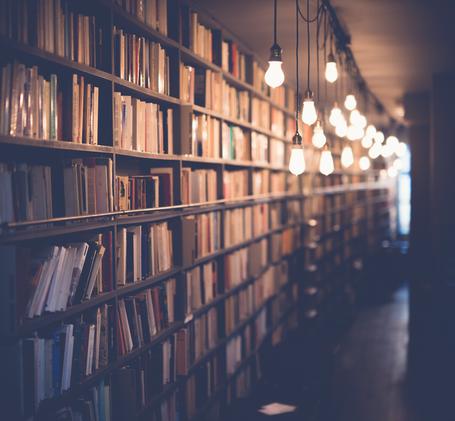

Ponte al día en tecnología y negocio con nuestros últimos ebooks.

10 términos básicos para ser un experto en Machine Learning.

Ebook - Machine Learning: 50 conceptos clave para entenderlo.

AWS Autopilot, pilotando hacia el futuro de la Inteligencia Artificial.

Big Things 2019: un evento de impacto.

¿Qué es un CAIO y por qué tu empresa va a contratar uno?

¿Dónde nacen los lenguajes de programación?

¿Cuál es la nueva estrategia española en IA y por qué es importante?

Apache Airflow, el nuevo director de orquesta de Google Cloud.

Cheat sheet sobre Pandas: acelerando el análisis de datos.

¿Qué tecnologías triunfarán en 2019?

Inteligencia Artificial, el futuro ya está aquí

Lo último en Tecnología y Negocio en solo 4 eBooks.

[Infografía] Cassandra, la dama de las bases de datos NoSQL.

¿Cómo convertirte en un experto en Inteligencia Artificial y Machine Learning?

Ebook - ‘Cómo acelerar tu negocio con Inteligencia Artificial Aplicada’

Inteligencia Artificial como servicio: reconocimiento de imágenes.

¿Es Python el lenguaje del futuro?

Curso de Big Data e Inteligencia Artificial.

De la ficción a la realidad: la maduración de la Inteligencia Artificial.

Open Data, o cómo los datos están cambiando el mundo.

Introducción a Django REST framework.

TensorFlow, o cómo será el futuro de la Inteligencia Artificial según Google.

Machine Learning para dummies.

Vuela con tus datos usando Apache Flink.

¿Es el Internet de las Cosas la siguiente revolución industrial?

Big Data en las nubes.

Codemotion 2016, a vista de pájaro.

Las Smart Cities llegan a España, ¿es tu ciudad inteligente?

VERSUS: Tablero Virtual VS Tablero Físico.

Jupyter: Data Science aplicada.

¿Qué puede aportar el Big Data al mundo de la medicina?

Cómo implementar microservicios con Python en minutos.

Crónica PyData Madrid 2016.

Machine Learning, la forma de hacer Big Data inteligente.

Channels, la apuesta de Django para modernizar el desarrollo de aplicaciones.

Cassandra, la dama de las bases de datos NoSQL.

Spark: un destello en el universo Big Data.

Cómo mejorar nuestras reuniones diarias de SCRUM usando el API de Jira.

Crónica del Codemotion 2015.

PyConES, primera conferencia de Python en España.

Conoce nuestra marca.

Conoce nuestra marca.

Conoce nuestra marca.

Conoce nuestra marca.

![(min-width: 768px) 40vw, 100vw [Infografía] Cassandra, la dama de las bases de datos NoSQL](https://www.paradigmadigital.com/assets/img/defaults/post.svg)