¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

techbiz

Roberto Torena 08/09/2025 Cargando comentarios…

La IA Generativa está reinventado el “Business Intelligence” y la capa semántica es la verdadera clave del éxito. En este post te contamos por qué.

Imagina poder preguntarle a tus datos en lenguaje natural: "¿cuáles fueron nuestros productos más rentables en Europa el último trimestre?" y recibir no solo una tabla, sino un análisis con gráficos y explicaciones. Esto ya no es ciencia ficción; es GenBI (Generative Business Intelligence).

La GenBI aprovecha la Inteligencia Artificial generativa (GenAI) para transformar la forma en que interactuamos con los datos, permitiendo a cualquier usuario descubrir, resumir y visualizar información a través de una simple conversación.

El término GenBI engloba un conjunto de soluciones diversas. Estas soluciones pueden clasificarse en función del nivel de complejidad técnica y potencial valor aportado (de menor a mayor):

Beneficios clave de las soluciones de GenBI para el negocio:

A pesar de similitudes tecnológicas con los proyectos de GenAI, las soluciones de GenBI tienen una complejidad adicional debido a la necesidad de garantizar una precisión absoluta y un gobierno de datos estricto. Algunas soluciones de GenAI pueden permitirse cierta ambigüedad, pero una solución de GenBI no puede proporcionar datos equivocados, ya que un error o "alucinación" podría llevar a decisiones de negocio catastróficas.

Adicionalmente, estos sistemas enfrentan desafíos clave como la comprensión profunda de los modelos de datos internos, el aprendizaje del contexto y la lógica de negocio específicos de la compañía y la implementación de una capa de seguridad robusta que respete los permisos de cada usuario.

Para hacer frente a estos desafíos, un enfoque simplista tiene poca probabilidad de éxito. Equipar a un agente de IA con una herramienta (tool) de conexión a la base de datos, obteniendo únicamente los metadatos técnicos (esquemas, tablas y campos) de la base de datos y esperando que genere comandos SQL correctos, ignora la complejidad inherente de los datos de negocio.

La probabilidad de que el comando SQL y la respuesta sea correcta es bajo debido a que los metadatos brutos carecen del contexto empresarial indispensable: no explican qué significan los campos o cuáles son las reglas de negocio o quién tiene permiso para acceder a qué información, llevando inevitablemente a errores, "alucinaciones" y brechas de seguridad.

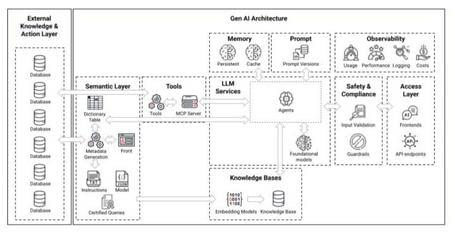

Por este motivo, en lugar de depender de la inteligencia en bruto del agente, se establece un paradigma de preparación semántica y control explícito. Este modelo consiste en construir una robusta base de conocimiento (knowledge base) que almacena toda la información curada: metadatos de negocio, reglas, instrucciones y ejemplos verificados. De esta forma, se transforma un modelo de lenguaje generalista en un agente IA de negocio fiable, dándole un entorno de conocimiento previamente definido y controlado.

Cuando un usuario realiza una consulta, el sistema no envía la pregunta directamente al LLM (Large Language Model). Primero, busca en la base de conocimiento todo el contexto semántico que es relevante para esa petición específica; a continuación, esta información se inyecta dinámicamente en el prompt que se envía al LLM. De esta manera, se le dan instrucciones precisas y el contexto necesario para generar el comando SQL correcto, asegurando la precisión, minimizando el riesgo de errores y forzando al modelo a operar dentro de un marco verificado que aplica la lógica de negocio y las reglas de gobierno definidas.

Este paradigma ha sido adoptado por un conjunto de plataformas de GenBI que surgen principalmente desde tres orígenes diferentes:

La elección de una plataforma comercial de Gen BI suele estar condicionada por el ecosistema tecnológico que la empresa ya utiliza, seleccionando la plataforma de BI o de datos que la empresa ya utiliza. Por este motivo, a continuación vamos a analizar las iniciativas open-source Vanna y Wren AI.

| Característica | Vanna | Wren AI |

|---|---|---|

| Solución | Librería de componentes de GenBI | Plataforma de GenBI |

| Madurez (*) | Inicio: 07/2023 Contribuciones: 20.2k stars Última versión: 0.7.9 |

Inicio: 05/2024 Contribuciones: 11.2k stars Última versión: 0.27.0 |

| Licencia | MIT: Sin limitaciones. |

AGPL-3.0 (generación de queries): en productos comerciales, se debe proporcionar el código fuente del producto completo. En soluciones internas, se debe proporcionar el código a los usuarios. Apache 2.0 (obtención de datos): Sin limitaciones . |

| Contexto usado en generación de comandos SQL | El LLM utiliza información de: Nombres y tipos de los campos Instrucciones de contexto y análisis Consultas verificadas |

El LLM utiliza información de: Nombres y tipos de los campos Instrucciones de contexto y análisis Consultas verificadas Sinónimos legibles de los nombres de los campos Descripciones de los campos y tablas Relaciones entre los campos |

| Conectividad | Programación manual de conectividad con bbdd y data warehouses. | El Wren Engine incluye un servidor MCP que facilita la conectividad con bbdd y data warehouses y un conversor de comandos SQL al dialecto que corresponda. |

| Interfaz desarrollador | Código Phyton | Interfaz visual |

| Interfaz usuario | Interfaz visual | Interfaz visual |

| Formato de respuesta | Comando SQL Tabla con resultados Gráfico |

Proceso seguido para la generación del comando SQL Comando SQL Tabla con resultados Respuesta en formato texto a la consulta Gráfico |

| Acuerdos con hiperescaladores | Designado "Google Cloud Ready - BigQuery" |

*Datos recogidos en septiembre 2025

Para construir una solución de GenBI eficaz, usando estas plataformas o construyendo desde cero, es necesario seguir un proceso de varias fases que van desde la definición del contexto de los datos hasta la ejecución final de las consultas. A continuación, se detalla cada una de estas fases y se ilustran con ejemplos de las principales plataformas.

El primer paso es un doble proceso de especialización: la creación de agentes de IA dedicados a dominios de negocio concretos y la meticulosa selección del subconjunto de datos que cada uno podrá consultar:

El primer paso es definir los agentes que se desarrollarán y los esquemas y tablas de datos de cada uno. Diseñar agentes enfocados en dominios de negocio específico (Ventas, Finanzas, etc.), en lugar de un "sabelotodo" genérico proporciona múltiples ventajas:

Para cada uno de los agentes definidos es preciso seleccionar los campos relevantes a ser utilizados de entre todos los disponibles para reducir la ambigüedad.

💡 Ejemplos:

Para que el agente pueda dialogar eficazmente con el usuario, ahora debemos construir un puente semántico: traduciendo los nombres técnicos de la base de datos a los términos del negocio y enriqueciendo el modelo con descripciones y relaciones que le enseñen al IA el verdadero significado de los datos.

Traducir los nombres crípticos de las tablas, campos y campos calculados (como fct_sls_rev) en etiquetas claras (VentasNetas) y legibles por el agente.

Añadir descripciones que definen su significado funcional de las tablas campos y campos calculados. Este proceso es crucial para que el agente entienda correctamente las preguntas de los usuarios.

💡 Ejemplos de traducción de nombres y descripciones:

Definir el modelo de datos estableciendo las relaciones entre las distintas tablas. Este es el mapa fundamental que permite al agente navegar el esquema y combinar información para responder a preguntas complejas que involucren varias entidades.

💡 Ejemplos de modelo de datos:

Más allá de los metadatos (nombres/alias, descripciones y relaciones), para lograr un rendimiento adecuado, es necesario proporcionar al agente guías con instrucciones explícitas del:

La calidad de estas instrucciones impactarán directamente en los resultados obtenidos.

💡 Ejemplos:

Cuando un usuario realiza una petición, el agente primero comprueba si existe una petición semánticamente similar entre las proporcionadas como ejemplo verificado. Si se encuentra, el SQL verificado es utilizado como base para generar la respuesta.

La provisión de peticiones y respuestas de ejemplo verificadas permite que el agente proporcione respuestas más precisas ante peticiones comunes, con mayor criticidad, más complejas o en las que se han identificado errores previos.

💡 Ejemplos:

Un requisito fundamental para cualquier solución de GenBI es su capacidad para conectarse a las fuentes de datos y ejecutar consultas de manera eficiente y segura. Cada solución aborda este desafío de maneras distintas, dependiendo de sus arquitecturas subyacentes.

Cuando es necesario conectar y ejecutar queries en múltiples BBDD o data warehouses (p. ej.PostgreSQL, MySQL, BigQuery, Snowflake) hay que abordar dos retos:

Un servidor Model Context Protocol (MCP) es un pilar de este diseño, proporcionando una interfaz estandarizada para que los agentes de IA interactúen con las herramientas de resolución de queries.

💡 Ejemplos:

Un requisito fundamental es la retroalimentación que permita a la solución aprender y mejorar continuamente con el uso. Para ello, es necesario habilitar un flujo de retroalimentación.

Cuando la plataforma de GenBI genera una consulta SQL correcta y útil, el usuario puede validarla y guardarla, a menudo con un solo clic, para que pase a formar parte del conjunto de ejemplos verificados (mencionado en la Fase 4). Análogamente, si la respuesta es incorrecta, la interacción es marcada y almacenada para revisión posterior por especialistas que permita proporcionar más ejemplos verificados, mejores instrucciones, etc. De esta manera, el sistema es cada vez más preciso y fiable cuanto más se utiliza.

Sin embargo, esta capacidad de que los usuarios enriquezcan el conjunto de entrenamiento introduce un riesgo significativo. Existe la posibilidad de que un usuario guarde una consulta SQL incorrecta o ineficiente, "contaminando" así la base de conocimiento del agente. Esto podría degradar el rendimiento futuro del sistema, especialmente en entornos con múltiples usuarios donde no todos tienen el mismo nivel de experiencia técnica. Por ello, es crucial implementar un mecanismo de gobierno o supervisión para asegurar la calidad de los ejemplos que se incorporan al modelo.

A medida que la GenBI madura, su evolución apunta hacia un futuro donde los sistemas de análisis de datos pasarán de ser herramientas reactivas a convertirse en socios proactivos y autónomos en la toma de decisiones, buscando anticipar necesidades, entender las causas raíz de los eventos y conectar los insights directamente con acciones de negocio concretas:

La irrupción de la GenBI marca un punto de inflexión en la relación de las empresas con sus datos. Estamos evolucionando desde un paradigma donde el acceso a la información era un privilegio de perfiles técnicos a una nueva era conversacional que promete democratizar el conocimiento y acelerar la toma de decisiones.

Sin embargo, el éxito de esta revolución no reside únicamente en la potencia de los LLMs para la generación de comandos SQL, sino en la construcción de un puente entre la IA y el contexto único de cada negocio. La capa semántica es la piedra angular de este puente, el elemento que transforma a un LLM generalista en un analista experto y fiable, capaz de entender la lógica, las reglas y los matices que definen a una organización.

El camino hacia una implementación exitosa de GenBI, ya sea a través de plataformas comerciales u open-source, exige un esfuerzo deliberado y meticuloso en la preparación semántica. Las fases de definición de agentes, enriquecimiento de metadatos, guía del razonamiento y retroalimentación continua no son meros pasos técnicos, sino una inversión estratégica fundamental. Este trabajo sienta las bases no solo para obtener respuestas precisas hoy, sino para habilitar la próxima generación de análisis autónomo.

Al dominar la capa semántica, las empresas no solo resolverán las preguntas actuales de forma más eficiente, sino que estarán construyendo el motor para el futuro en el que la IA no solo responda, sino que anticipe, prescriba y actúe, convirtiéndose en un verdadero socio en la creación de valor.

Los comentarios serán moderados. Serán visibles si aportan un argumento constructivo. Si no estás de acuerdo con algún punto, por favor, muestra tus opiniones de manera educada.

Cuéntanos qué te parece.