¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

dev

Javier Agüero 30/06/2016 Cargando comentarios…

Este año el AWS Summit Madrid 2016 nos dejó a todo el equipo de Sistemas de Paradigma un muy buen sabor de boca. Como ya hemos contado, el evento se dividió en tres bloques de charlas paralelas, por lo que tuvimos que ingeniárnoslas para no perdernos ninguna. Después de contar en el blog de qué se habló en las conferencias Innovación en el mundo Enterprise y Go! Build!, cerramos el ciclo hablando de Agilidad en Cloud.

El título de la primera charla ya prometía. Que un miembro de AWS te explique cómo trabajar la estrategia de gestión de información en AWS Cloud es, como poco, interesante. Abrió la charla Antonio Álvarez, Business Development Manager en AWS, ante un buen número de asistentes expectantes. Comenzó hablándonos de las ventajas que proporciona AWS frente a tener la información en nuestro propio datacenter:

En principio nada nuevo, pero nunca viene mal recordar todas las ventajas, o al menos las más importantes, de tener nuestro propio centro de datos. Algo obvio, pero que todavía muchas empresas ignoran. Posteriormente enumeró distintos servicios que proporciona AWS para la gestión de la información:

Dentro del marco del tratamiento de la información, Antonio Álvarez nos habló también de un nuevo servicio y de varias herramientas muy interesantes a la hora de querer migrar a AWS:

Database Migration Service (DMS)

Se trata de un servicio que nos permitirá migrar nuestra BD, tabla o esquema a AWS, cambiando incluso el motor de la BD para utilizar cualquiera de los que nos permite AWS como servicio. Una característica muy importante de este servicio es que se realiza sin pérdida de servicio. Podremos realizar una migración inicial y posteriormente ir haciendo sincronizaciones hasta que finalmente decidamos utilizar la BD que tenemos en AWS. Lo único que necesitamos hacer es conectar nuestro datacenter con AWS, lanzar la herramienta y mantenerlo sincronizado.

Se trata de una herramienta gratuita que nos permite migrar de nuestra BD Oracle o SQLServer a MySQL, Aurora, MariaDB o PostgreSQL en AWS. La herramienta realizará un análisis de nuestra BD y nos indicará el porcentaje que puede enviarse al destino. También proporciona una buenas prácticas para la migración.

Se trata de una herramienta de BI (Business Intelligence) en memoria optimizada para analítica, muy rápida y que permite compilar visualizaciones, realizar análisis personalizados y obtener perspectivas empresariales a partir de nuestros datos. Está abierta a herramientas de terceros como Tableau.

Después de la parte teórica, del caso de uso se encargó David Muñoz**,** CTO de Wallapop, una startup española que ha logrado un asombroso éxito en muy poco tiempo. David Muñoz explicó que tenían todo el entorno de producción de Wallapop en AWS y que, gracias a la flexibilidad que proporciona, pudieron corregir los fallos que habían cometido en un principio y solventarlos. Para terminar, hizo un resumen de las tecnologías que ellos utilizaban:

Fue muy enriquecedor escuchar de primera mano un caso de uso tan interesante como el de Wallapop, sin duda, toda la una referencia de startup que trabaja íntegramente con tecnologías basadas en Cloud.

La siguiente charla la impartió Miguel Rojo, AWS Solutions Architect, que comenzó con la siguiente y rotunda afirmación: “Las aplicaciones monolíticas son del pasado”, una frase con la que explicaba que van perdiendo agilidad y la consecuencia es que cada vez se van haciendo menos despliegues.

Debido a esto surgen las arquitecturas orientadas a servicios (SOA), que se comunicaran vía API o los microservicios, centrados en su propia “burbuja”, realizando su propia tarea y proporcionando así una mayor agilidad.

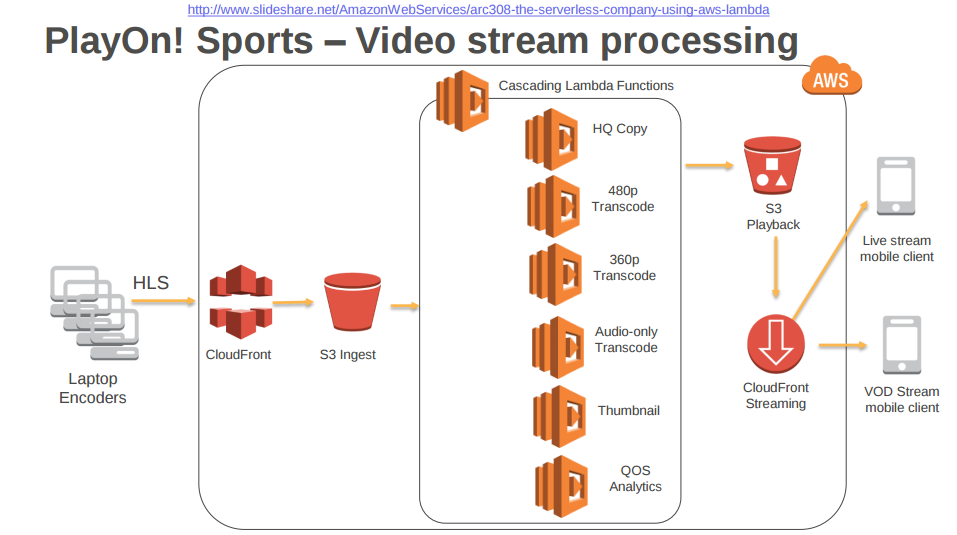

Todo ello nos lleva a tecnologías Serverless, que proporcionan mayor tiempo para la lógica de negocio y permiten el escalado por definición. Para hacer uso en AWS de este tipo de tecnologías tenemos:

AWS Lambda es un servicio de computación sin servidores que ejecuta el código como respuesta a eventos y administra automáticamente los recursos de computación subyacentes.

Podemos crear funciones Lambda en Java, NodeJS y Python. Además, la manera de subir el código será mediante la consola de AWS y se escala automáticamente. También puede interactuar con otros servicios de AWS y se integra con CloudWatch.

Para la securización se recurre a IAM roles. Otra de sus características es que los recursos para las funciones Lambda se harán en bloques de 64 MB de memoria, y la CPU, red y E/S de disco se asignará en función de dicha memoria. Esto hace que el tiempo máximo de ejecución sea de 5 minutos.

Además, por defecto tendrá acceso a Internet, pero tendremos que personalizar los Security Groups e integrarla con un Internet Gateway para dicha salida a Internet. Podemos facturar por el número de invocaciones a la función y el tiempo en milisegundos de respuesta, en bloques de 100 milisegundos (Amazon ofrece el primer millón de invocaciones a la función sin coste). Hay que tener en cuenta que tiene una comunidad de desarrolladores muy grande respaldándola.

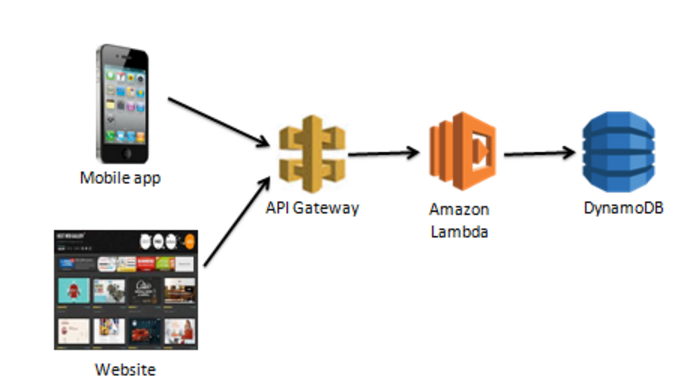

Siguiendo con el uso de microservicios, en la charla no pudo faltar la mención a Amazon API Gateway, que se integra a la perfección con Lambda haciendo de “puerta delantera” para microservicios o aplicaciones. Su uso nos permitirá:

Como consejo o “best practices” hicieron mucho hincapié en limitar las funciones. Un ejemplo de diseño para un servicio web sería:

El encargado de esta última sesión fue Javier Ros, AWS Technical Account Manager, que comenzó con una reflexión de cómo los datos aumentan en variedad, velocidad y volumen. Según Ros, el tratamiento de la información en Big Data tiene las siguientes fases:

En todo este proceso, debemos tener en cuenta:

Para saber qué tipo de instancias de AWS debemos elegir para crear una infraestructura, debemos tener en cuenta las instancias Spot, que son los recursos de computación sobrantes de AWS, los cuales se ponen a disposición de los usuarios mediante un sistema de subasta. El precio de estos recursos fluctúa según las condiciones del mercado. Estas instancias nos permiten ahorrar hasta un 80-90% del precio final.

En esta charla, Javier Ros no quiso olvidar un concepto que está sumamente de moda y muy ligado al tratamiento de información en Big Data que es el Machine Learning. Para ello habló de la siguiente herramienta:

Ros lo definió como un servicio de aprendizaje automático que permite estudiar patrones y es capaz de hacer predicciones. Entre sus características destacaron las siguientes:

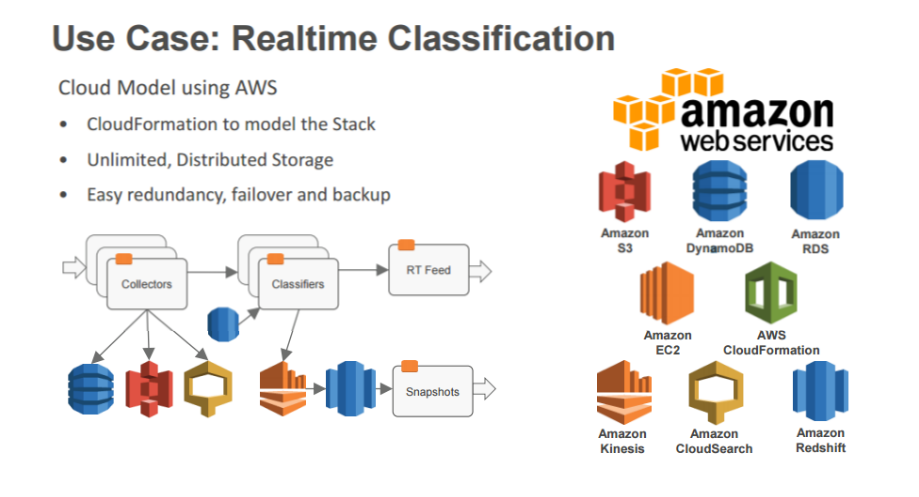

Como caso de uso hizo su ponencia José Luis Cruz, Operations Manager de RavenPack, empresa dedicada a hacer analíticas de Big Data para el mundo financiero. Explicaron que lo que AWS les había permitido era flexibilidad, escalabilidad y pago por uso. Mostraron un esquema de su infraestructura:

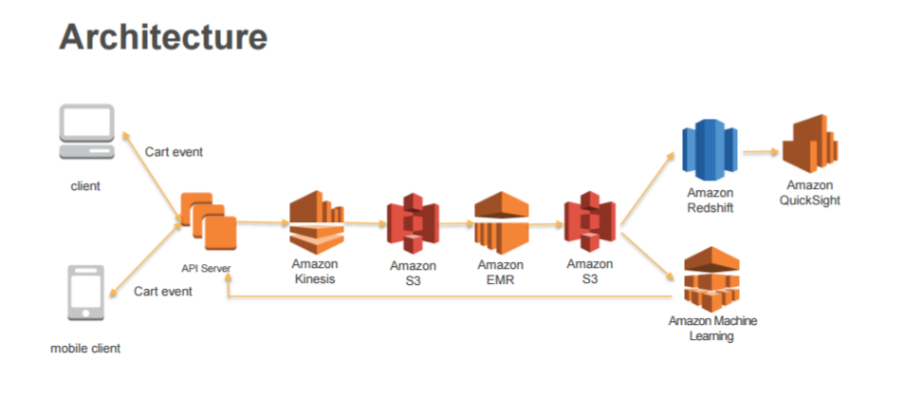

Para finalizar, Javier Ros puso como ejemplo de uso de Big Data un carrito de la compra de una tienda Online, como por ejemplo Amazon:

Después de asistir a las 3 charlas puedo decir que cada vez se aboga más por las infraestructuras serverless, el uso de microservicios y tratar gran cantidad de información. Gracias a los casos de uso de estas conferencias hemos podido ver cómo grandes empresas utilizan AWS para la gestión, tratamiento y almacenaje de sus datos, exponiendo la infraestructura desplegada y evidenciando que en un principio pudieron equivocarse en el diseño de la arquitectura, pero gracias a la flexibilidad de AWS, permite modificarla y escalar de manera sencilla.

No cabe duda de que este es el camino a seguir, apostar por la innovación tecnológica para no quedarnos atrás, para cumplir con lo más importante: las expectativas y las demandas de nuestros clientes, sea cual sea el tamaño de nuestra empresa.

Los comentarios serán moderados. Serán visibles si aportan un argumento constructivo. Si no estás de acuerdo con algún punto, por favor, muestra tus opiniones de manera educada.

Cuéntanos qué te parece.