¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

techbiz

Roberto Torena 02/07/2025 Cargando comentarios…

En el vertiginoso mundo de la IA predictiva y generativa, las plataformas de los hiperescaladores (AWS, Azure y GCP) se han consolidado como un punto de partida interesante para muchas empresas.

Su principal atractivo radica en que simplifican el ciclo de vida de las soluciones de IA, ofreciendo un ecosistema integrado, reduciendo drásticamente la barrera de entrada y acelerando la creación de soluciones.

Los servicios de LLMs, como los ofrecidos por OpenAI y Anthropic, facilitan el acceso de forma sencilla e inmediata a modelos de última generación a través de una simple llamada de API acelerando drásticamente la innovación.

Sin embargo, esta conveniencia conlleva contrapartidas importantes que pueden frenar a una empresa a largo plazo:

Es aquí donde emerge con fuerza el ecosistema de código abierto, que promete devolver el control a los equipos de desarrollo, ofreciendo transparencia, personalización y la soberanía sobre el código, los datos y la infraestructura.

Sin embargo, adoptar una estrategia puramente de código abierto, introduce sus propios desafíos empresariales: la complejidad de integrar, gestionar, securizar y mantener un stack tecnológico dispar.

Aquí es donde una solución como Red Hat AI marca la diferencia. Red Hat AI capitaliza toda la innovación y flexibilidad del ecosistema de código abierto, pero la envuelve en una plataforma empresarial consistente, segura y soportada.

Permite a las empresas entrenar, servir y monitorizar sus propios modelos de IA en la infraestructura que elijan, ya sea on-premise o en cualquier nube pública.

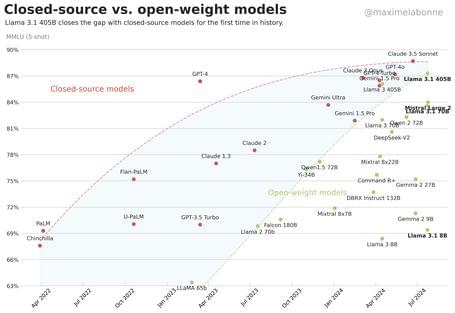

Una plataforma de IA abierta no solo te da la libertad de ejecutar Large Language Models (LLMs), también te da el poder de adaptarlos y mejorarlos. El ritmo acelerado de las comunidades abiertas ha generado que los modelos abiertos ya compiten cara a cara con sus alternativas propietarias, como demuestran los análisis MMLU (Massive Multitask Language Understanding).

** Fuente de la imagen: Maxime Labonne

En ocasiones es necesario alinear (hacer “fine-tunning”) un LLM para que se ajuste a las necesidades de un proyecto. Este proceso requiere bifurcar un modelo abierto existente y utilizar amplios recursos computacionales y grandes cantidades de información. Además, no es posible incorporar las mejoras obtenidas al modelo original.

¿Hay alguna forma de hacer este proceso más abierto y colaborativo? Sí, Red Hat ha creado InstructLab, un proyecto de código abierto que mejora el proceso de “fine-tunning” y facilita la contribución en el desarrollo de estos LLMs abiertos.

¿Cómo funciona?

Una vez que tienes un LLM adecuado para tu aplicación, el siguiente reto es desplegarlo para que responda a las peticiones de los usuarios (inferencia).

Los LLMs abiertos con mejores prestaciones requieren hardware potente (como GPUs), lo que presenta un dilema económico en cuanto a su despliegue:

Esto causa que, para cargas de trabajo con un volumen bajo o moderado, el modelo de pago por uso de servicios de LLMs (por ejemplo, OpenAI o Anthropic) sea económicamente más eficiente.

¿Es posible optimizar el uso de la infraestructura ejecutando inferencias de LLMs y mejorar su rentabilidad?

En 2023, el artículo “Efficient Memory Management for Large Language Model Serving with PagedAttention” concluye que los sistemas existentes tienen un problema de gestión ineficiente de la memoria que, puede ser desperdiciada por fragmentación y duplicación, e introduce vLLM, un algoritmo inspirado en la paginación de memoria virtual, para eliminar casi por completo este desperdicio y aumentar drásticamente el rendimiento.

Inspirados por ese artículo, el proyecto opensource vLLM ha desarrollado una librería para la inferencia y el servicio de LLMs con alto rendimiento.

Red Hat AI Inference Server es un servidor de inferencia de LLMs de nivel empresarial, surgido del proyecto vLLM que ofrece:

¿Y cómo escala cuando la demanda crece?

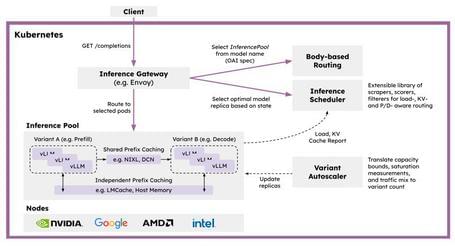

CoreWeave, Google, IBM Research, NVIDIA y Red Hat han lanzado la comunidad llm-d. Aprovechando la innovación de vLLM y las capacidades de Kubernetes, llm-d sienta las bases para una inferencia de IA distribuida, escalable y de alto rendimiento.

** Fuente de la imagen: llm-d.ai

Las principales funcionalidades que llm-d proporciona son:

Un LLM, aunque sea el componente central, es solo una pieza dentro de un sistema de IA generativa robusto y de nivel empresarial. Para que estos modelos aporten un valor real, necesitan estar integrados en una plataforma que gestione todo su ciclo de vida: desde la experimentación y la gestión de datos hasta el despliegue, la orquestación y la monitorización.

Red Hat OpenShift AI es la plataforma integral que permite a tus equipos construir, desplegar y gestionar aplicaciones de IA predictiva y generativa de principio a fin. Está construida sobre el proyecto Open Data Hub e integra las mejores herramientas de código abierto para cada fase del ciclo de vida:

| Funcionalidad | Herramienta | Descripción |

|---|---|---|

| Recolección y preparación de datos | Pachyderm | Plataforma para la automatización de pipelines de datos, con versionado y linaje de datos inmutables. |

| Trino | Motor de consultas SQL distribuido para ejecutar análisis federados sobre diversas fuentes de datos. | |

| Ceph | Plataforma de almacenamiento distribuido, unificado y definido por software, diseñada para ser escalable. | |

| Feature engineering y desarrollo del modelo | InstructLab | Proyecto de código abierto que mejora el proceso de “fine-tunning” y facilita la contribución en el desarrollo de LLMs abiertos. |

| TensorFlow, PyTorchy CUDA | Herramientas en el ecosistema de Python para el desarrollo de modelos de IA, ofreciendo capacidades de entrenamiento en GPU, y desarrollo de modelos con redes neuronales. | |

| JupyterLab | Entorno de desarrollo interactivo basado en web para la creación de notebooks, código y visualizaciones. | |

| Elyra | Extensión para JupyterLab que permite crear y ejecutar pipelines de IA/ML de forma visual. | |

| Visual Studio Code | Editor de código fuente ligero, pero potente con soporte para múltiples lenguajes y un amplio ecosistema de extensiones. | |

| RStudio | Entorno de desarrollo integrado (IDE) específico para el lenguaje de programación R, popular en estadística y ciencia de datos. | |

| Pipeline de entrenamiento y validación del modelo | Ray | Framework de código abierto para escalar aplicaciones de IA y ML, desde ordenadores personales hasta grandes clústeres. |

| Kubeflow | Plataforma que simplifica y escala el despliegue de flujos de trabajo de aprendizaje automático (ML) en Kubernetes. | |

| CodeFlare | Framework que simplifica la ejecución de cargas de trabajo de computación distribuida (como Ray y PyTorch) en OpenShift. | |

| Tekton | Framework nativo de Kubernetes para crear pipelines de entrega continua (CI/CD) flexibles y potentes. | |

| Servicio del modelo | Red Hat AI Inference Server/vLLM | Servidor de inferencia de LLMs de nivel empresarial surgido del proyecto vLLM. |

| KServe | Plataforma de servicio de modelos en Kubernetes que proporciona inferencia escalable para cargas de trabajo de ML. | |

| CI/CD | Argo | Conjunto de herramientas nativas de Kubernetes para la entrega continua (CI/CD) y prácticas basadas en GitOps. |

| Monitorización | Grafana | Plataforma de código abierto para la visualización, monitorización y análisis de métricas y logs. |

| Prometheus | Sistema de monitorización y alerta de código abierto, diseñado para recopilar y consultar métricas en tiempo real mediante una base de datos temporal. | |

| TrustyAI | Conjunto de herramientas de IA Explicable (XAI) diseñado para evaluar la explicabilidad, equidad y confianza de los modelos de IA. |

Además, Red Hat OpenShift AI se integra con un robusto ecosistema de partners tecnológicos como Starburst, HPE, Elastic, NVIDIA e Intel para extender aún más sus capacidades (pueden requerir licencias adicionales).

En un panorama donde la IA a menudo exige comprometer la soberanía de los datos, aceptar costes impredecibles y quedar atado a un único proveedor, Red Hat AI ofrece una alternativa estratégica.

Al unificar la innovación sin límites del código abierto (desde la mejora colaborativa de modelos con InstructLab hasta la inferencia ultra eficiente con vLLM) dentro de una plataforma empresarial completa y segura, te devuelve el poder de decisión.

Ya no tienes que elegir entre la velocidad y el control, o entre la potencia y la flexibilidad. El futuro de la IA es abierto y con Red Hat puedes construirlo a tu medida.

Los comentarios serán moderados. Serán visibles si aportan un argumento constructivo. Si no estás de acuerdo con algún punto, por favor, muestra tus opiniones de manera educada.

Cuéntanos qué te parece.