¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

techbiz

Javier Renovell 30/09/2015 Cargando comentarios…

Ahora que se acerca el evento Big Data Spain a celebrar el 15 y 16 de octubre, querría llamar la atención sobre el fenómeno del Big Data, una de las cinco megatendencias que los analistas y tecnólogos no paran de aventar contra los CIOs y CEOs de medio mundo para seguir justificando su papel de gurús.

¿Necesidad real o moda pasajera? Big Data no es solo una de las buzzword del momento, pues en rigor se lleva ya más de veinte años trabajando sobre el concepto y la tecnología subyacente que ha hecho posible construir Internet tal como la encontramos ahora: Yahoo!, Google, Amazon, eBay, Facebook…

En su día, cuando Larry Page y Serguéi Brin comenzaron en 1996 su fantástica aventura como un proyecto de postgrado en la Universidad de Stanford, ya tenían en mente la enorme cantidad de datos a manejar y organizar en la Web, de ahí que bautizaran a su motor de búsqueda Google inspirados por el término matemático "gúgol" que se refiere al número uno seguido por cien ceros.

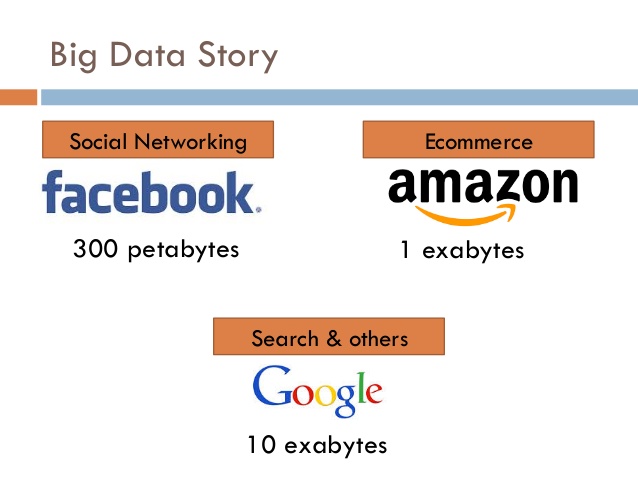

La explosión de datos es imparable y además se acelera con el tiempo. En 2010, el entonces director general de Google, Eric Schmidt, realizó un cálculo: hasta 2003, todo el saber acumulado desde los albores de las civilizaciones podría caber en un “disco” (si es que se pudiera fabricar uno así) de 5 exabytes. Solo siete años después, esa cantidad equivalía a la publicada en Internet cada dos días.

En 2015, Yahoo! maneja con soltura 180 petabytes, Goggle casi el doble, 300 PB. Si sumamos toda la información almacenada en todos los servidores, nos vamos a esos pocos (por ahora) EB que ocupa Internet. Cantidades impensables incluso para cualquier multinacional europea.

No digamos españolas, la información más relevante de las empresas del IBEX 35 no ocupan más de 10 terabytes, no sólo la estructurada en sus tablas, estadísticas, programas de contabilidad y fichas de cliente (que puede suponer el 15%), sino añadiendo toda la parte semiestructurada de PDF y PPT, o la directamente desestructurada de comentarios en Internet, correos electrónicos internos y externos, e incluso las llamadas de voz al call center.

Entonces, ¿no hace falta Big Data para mi negocio? Claro que sí. Siempre que entendamos que “Big” no es por lo grande, sino por lo importante.

Realmente Big Data trata de extraer valor a los datos disponibles, como ya viene explicando nuestra COO Carmen Vidal desde hace tiempo, procesar todo tipo de información a nuestro alcance para obtener una ventaja competitiva, hacer más efectivos nuestros productos y servicios, generar un margen mayor en cada operación, y que el número de operaciones se puedan incrementar a una escala global de manera correlativa.

No se trata de meter esteroides en el sistema y hacer los datos más aparentes trabajando las rutinas en el gimnasio. El análisis de los datos es una metodología ya explorada en el pasado, con los almacenes de datos (Data Warehouse), la minería de datos (Data Mining) y la inteligencia de negocio (Business Intelligence).

Pero tenían un límite: la consistencia del dato impedía jugar con él. No se le podía cruzar con otro tipo de datos de diferente pelambre, no se podía procesar grandes volúmenes de datos no estructurados, no se le podía enriquecer con diversos supuestos y escenarios.

Google tuvo que enfrentarse en su inicio con la tecnología disponible (básicamente basada en bases de datos relacionales), y al no servirle para su propósito, inventar la suya propia, desarrollando capacidades de proceso a escala basadas en binomios de clave/valor, algoritmos cada vez más refinados y código por un tubo.

Pero la revolución llegó con los sistemas definidos por software, la computación en memoria y en especial la lectura columnar de las tablas y no solo por filas. Realmente, se podían hacer muchas cosas nuevas con máquinas “normales”, abaratándose enormemente la capacidad de proceso, creando aplicaciones ad-hoc para propósitos departamentales y añadiendo una nueva dimensión a la definición y creación de negocios puramente digitales: la imaginación

Pero además de aplicarse el Big Data a los buscadores (Paradigma lleva ayudando en esta tarea a diversas entidades financieras y de recursos humanos, entre otras), están surgiendo herramientas específicas para el web mining, para poder oír la conversación que se produce en Internet y las redes sociales acerca de nuestra marca, poder procesarla, y poder extraer no sólo métricas sino también análisis semánticos y de sentimiento (NH Hoteles...).

Otra aplicación se refiere al comportamiento de los usuarios, tanto a la hora de realizar una compra on-line o contratar un seguro, como al proceso fallido de la operación. Sin embargo, van a ser las aplicaciones M2M y el Internet de las Cosas las que sin duda supondrán un espaldarazo definitivo para este tipo de metodologías.

Es aquí donde los departamentos TI se encuentran en un gran aprieto, pues no cuentan precisamente con personal experto en nómina en este tipo de desarrollos. Es una tecnología que evoluciona muy rápidamente, basada en estándares abiertos y ciencia pura de los números.

Sin duda un hito lo constituyó en su día Hadoop, el servidor Apache escrito en Java y basado en procesamiento en batchs (por lotes) y sistema distribuido de archivos a escala PB que recibió el apoyo unánime de la industria. Pero eso es Big Data 1.0; los expertos en la conferencia Big Data Spain ya están hablando de la siguiente ola, Big Data 2.0 basada en analítica predictiva en tiempo real, se puede lograr con los nuevos servidores Spark.

Se trataría ahora de intentar aprovechar de la experiencia de los desarrolladores acostumbrados a trabajar con sentencias SQL basados en el principio de coherencia (lo que limitaba su alcance) para implementarla en un mundo NoSQL escrito para el rendimiento a escalas de TB en adelante.

El resultado: nuevas aplicaciones de análisis interactivo y predictivo capaces de ofrecer búsquedas personalizadas y recomendaciones a través de los llamados bubble filters como en Netflix, Flipboard, Spotify, Amazon, Facebook o los servicios más populares de Google. Del Big Data al Fast Data: en la Web, los datos instantáneos tienen igual o mayor valor que los históricos; y en Internet histórico significa de ayer. Otro reto para el futuro que dejo apuntado: el Big Data-as-a-Service.

Si hubiera que elegir un argumento de venta para la aplicación de Big Data a su negocio, sería éste: el de poder pasar del riesgo de una intuición a la fórmula matemática que garantice la correcta decisión. Nada de indefinidos hipermegalones (como se dobló en la película Regreso al Futuro III gúgolplex, un uno seguido por un gúgol de ceros). Sólo algoritmos con intuición e imaginación.

Los comentarios serán moderados. Serán visibles si aportan un argumento constructivo. Si no estás de acuerdo con algún punto, por favor, muestra tus opiniones de manera educada.

Estamos comprometidos.

Tecnología, personas e impacto positivo.

Cuéntanos qué te parece.